Qualitätsmaße für ADM Systeme

Was ist eine gute Entscheidung?

Insbesondere dann, wenn algorithmische Entscheidungssysteme (ADM Systeme) sensible Entscheidungen

unterstützen oder treffen sollen, ist es wichtig, dass diese Entscheidungen qualitativ hoch wertig

sind. Um die Qualität einer Entscheidung zu beurteilen, benötigen wir zunächst eine Definition einer

guten Entscheidung.

Wann eine Entscheidung „gut“ ist, wird aus der Perspektive der Informatik anhand von Metriken

festgestellt. Hierbei wird verglichen, wie gut der trainierte Algorithmus die tatsächlichen

Ergebnisse auf einem Testdatensatz (Grundwahrheit) vorhersagen kann. D.h., das System bekommt Daten,

trifft eine Entscheidung oder macht eine Vorhersage, z.B. über die Kreditwürdigkeit einer Person.

Diese Entscheidung wird dann verglichen mit der Kreditwürdigkeit der Person, die in diesem

Testdatensatz bekannt war. Dabei nutzen die Informatiker etablierte Maße aus den

Sozialwissenschaften, wie etwa die „erklärte Varianz“ (Bestimmtheitsmaß) oder mathematische

Metriken, die auf der Konfusionsmatrix basieren, um die Qualität zu bewerten.

Während des Trainings von algorithmischen Entscheidungssystemen wird ein solches Qualitätsmaß

genutzt, um zu bestimmen, ob das System schon gut genug ist, um verwendet zu werden. Ist dies nicht

der Fall, wählt das Entwicklungsteam entweder ein anderes maschinelles Lernverfahren, verändert die

Datengrundlage oder einen der Parameter des bisherigen Verfahrens. Unter "Parameter" versteht man

alle Zusatzinformationen, die man dem Verfahren mitgeben kann. Im Beispiel des Entscheidungsbaumes

kann zum Beispiel eingestellt werden, nach welchem Verfahren genau die nächste Frage in jedem

Schritt bestimmt wird, oder wie viele Fragen hintereinander maximal gestellt werden dürfen. Die

meisten Verfahren haben also viele Schalter und Knöpfe, an denen gedreht werden kann, um das

statistische Modell zu erstellen – es handelt sich also nicht um ein völlig deterministisches,

objektives Verfahren, das aus Daten automatisch die bestmöglichen Muster herausliest, um zukünftige

Entscheidungen zu treffen. Das Trainieren von ADM Systemen ist ein Handwerk und bedarf daher jeweils

vieler Entscheidungen und Gestaltung, wozu eben auch die Wahl des Qualitätsmaßes gehört. Die meisten

Metriken basieren dabei auf der sogenannten Konfusionsmatrix, die für alle ADM Systeme genutzt

werden kann, die Personen oder Objekte in eine von zwei Klassen eingruppieren.

Eine Konfusionsmatrix (auch: Wahrheitsmatrix) beschreibt für eine Menge von Testdatensätzen wie gut

sich das ADM System geschlagen hat. Dafür nimmt man die im Testdatensatz bekannte Klassifizierung

und vergleicht sie mit der Klasse, die das ADM System berechnet hat. Es kann vier Fälle geben.

Zuerst die zwei, wo die Berechnung mit der echten Klassifizierung übereinstimmt. Das sind auf der

einen Seite die Menge von richtig-positiven Vorhersagen („true positive“, TP), und auf der anderen

Seite die der richtig-negativen Prognosen („true negative“, TN). Daneben gibt es die Fälle, in der

Berechnung und wahre Klassifizierung voneinander abweichen, also die Menge der falsch-positiven

(„false positive“, FP) und die der falsch-negativen („false negative“, FN) Fälle. Die

Konfusionsmatrix enthält nun jeweils die Anzahl der Fälle in jeder dieser Kombinationen. Die auf den

ersten Blick verwirrende Benennung von "negativen und positiven" Testergebnissen kommt übrigens aus

der Medizin: Hier ist ein Test "positiv", wenn damit eine Krankheit erkannt wird, und negativ, wenn

der Patient oder die Patientin nicht krank ist. Damit wird auch schon klar, dass die Einteilung in

die "positive Klasse" kein wirklich positives Ereignis sein muss – genauso wenig wie ein positives

Testergebnis in der Medizin ein positives Ereignis sein muss. Meistens wird diejenige Klasse als

positiv bezeichnet, die für den Verwender des Systems wichtiger ist: Die Klasse der vermutlich

erfolgreichen Arbeitnehmer:innen, die Klasse der Personen, die vielleicht das Studium abbrechen oder

die der Personen, die vermutlich bald eine Straftat begehen werden.

Wir zeigen eine fiktive Konfusionsmatrix am Beispiel des Entscheidungsbaumes für die

Studienabbrecher. Für die Vorhersagen ergibt sich Folgendes:

| Person beendet Studium | Person bricht Studium ab | |

|---|---|---|

| Entscheidungsbaum tippt auf Studienabbruch | richtig positiv (TP) | falsch positiv (FP) |

| Entscheidungsbaum tippt auf Studienabschluss | falsch negativ (FN) | richtig negativ (TN) |

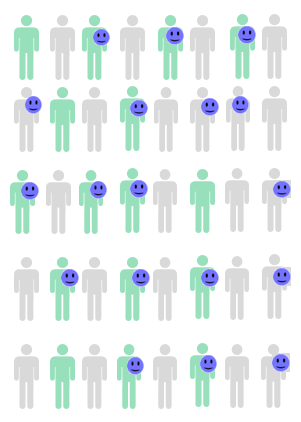

- (1) TP= Die grün eingefärbten Menschen mit Smiley beenden ihr Studium und werden durch das System der richtigen Klasse zugeordnet.

- (2) FN= Die grün eingefärbten Personen ohne Smiley beenden ihr Studium, werden durch das System jedoch fälschlicherweise der Klasse zugeordnet, die ihr Studium nicht beendet.

- (3) TN=Die grau eingefärbten Menschen mit Smiley brechen ihr Studium ab und werden durch das System der richtigen Klasse zugeordnet.

- (4) FP= Die grau eingefärbten Menschen ohne Smiley brechen ihr Studium ab, werden durch das System jedoch fälschlicherweise der Klasse zugeordnet, die ihr Studium beendet.

| Konfusionsmatrix | Person beendet Studium | Person bricht Studium ab | |

|---|---|---|---|

| Maschine tippt auf Abbruch | TP=12 | FP=6 | Summe: 18 Mal Vorhersage des Abbruchs |

| Maschine tippt auf Abschluss | FN=4 | TN=18 | Summe: 22 Mal Vorhersage des Abschlusses |

| Summe: 16 Personen haben das Studium beendet | Summe: 24 Personen haben Studium abgebrochen |

Sensitivität oder Richtig-Positiv-Rate (im Englischen auch: Recall)

Dieses Maß berechnet das Verhältnis der Beobachtungen, die korrekt positiv vorhergesagt wurden zur Gesamtzahl der Beobachtungen, die tatsächlich zu den positiven Beobachtungen zählen. In einem medizinischen Test sind es die Kranken, die auch durch den Test entdeckt werden – im Beispiel mit den Studienabbrecher:innen sind es diejenigen, die auch die Maschine entdeckt. Die Formel zur Berechnung dieses Maßes lässt sich wie folgt darstellen:

Die Formel lässt sich wie folgend erklären: Man teilt die Anzahl der korrekt Identifizierten durch alle Personen, die entweder korrekt identifiziert wurden durch die Maschine oder fälschlicherweise nicht von ihr entdeckt wurden. Die Summe aus den beiden Zahlen entspricht also allen Personen, die tatsächlich zu den Studienabbrecher:innen gehören. Im Beispiel sind dies 18 von 24, also 66,67%.

Es ist sehr einfach, einen Test zu schaffen, der alle Personen einer Klasse entdeckt und damit eine 100%-ige Sensitivität erreicht: Dazu muss man einfach nur alle Personen dieser Klasse zuteilen. Damit hat man insbesondere auch diejenigen in die Klasse eingeteilt, die dorthin gehören. Da dies natürlich nicht sinnvoll ist, muss man bei jedem ADM System (oder medizinischem Test) nicht nur die Sensitivität betrachten, sondern auch ihr Gegenstück, die Spezifität.

Spezifität oder Richtig-Negativ-Rate

Hier wird der Anteil aller Personen berechnet, die zur anderen Klasse gehören und von der

Maschine korrekt erkannt wurden. In dem Beispiel mit den Studiumsabbrecher:innen sind es

also diejenigen, die das Studium erfolgreich abgeschlossen haben und als solche von dem

System identifiziert wurden. In diesem Beispiel sind es also 12 von 16, also 75%.

Daneben gibt es noch über 20 weitere Qualitätsmaße, von denen wir nur noch das wohl

geläufigste Maße vorstellen, die Korrektklassifikationsrate (Accuracy).

Korrektklassifikationsrate (Auf Englisch: Accuracy)

Das Maß Accuracy (Genauigkeit) ist die am häufigsten verwendete Kennzahl zur Bewertung von

Klassifikatoren. Sie stellt den Prozentsatz der gesamten Beobachtungen dar, die korrekt

klassifiziert wurden.

Die Formel zur Berechnung der Accuracy ergibt sich wie folgt:

Die Formel lässt sich wie folgend erklären: Oben im Zähler werden alle korrekten Vorhersagen zusammengerechnet. Im Beispiel also die Anzahl der korrekt berechneten Abbrecher und Abschließer. Im Nenner werden alle Fälle zusammengezählt, also alle Entscheidungen, die getroffen wurden. Für das Beispiel liegt der Anteil der korrekten Entscheidungen also bei (12+18)/40, also bei 75%.

Das Hauptproblem dieses Maßes besteht darin, dass die Qualität der Klassifikatoren nicht widergespiegelt wird, sofern auf einem unbalancierten Datensatz trainiert wurde. Besteht in einem Datensatz beispielsweise ein unausgewogenes Klassenverhältnis von 3:97, so wird eine Korrektklassifikationsrate (Accuracy) von 97% schon alleine dadurch erreicht, dass man für alle Personen vorhersagt, sie seien in der Mehrheitsklasse. Da statistische Lernverfahren bei der Optimierung der Accuracy dazu neigen, vorhandene Beobachtungen einer kleinen Klasse zu ignorieren, würde bei neuen Beobachtungen entsprechend verstärkt die große Klasse vorhergesagt werden.

Neben den drei genannten Qualitätsmaßen für ADM Systeme gibt es ca. 20 weitere. Da das Qualitätsmaß darüber bestimmt, ob ein System schon eingesetzt werden kann oder weiter trainiert werden muss, ist die Wahl überaus wichtig und sollte sorgfältig gemacht werden.